在数字的迷雾中,潜藏着智慧的深海——《深邃探秘:智识之海的呼唤》。这是一场科技与幻想交织的探险,故事始于一位寻常程序员的不寻常决定:将传说中的思维引擎DeepSeekR1,从云端的神秘领域牵引至个人电脑的硬盘深处。在光标闪烁的命令行界面下,他键入那串开启智慧之门的密令:“ollama run deepseek-r1:7b”,瞬间,他的世界被颠覆。

DeepSeek,这不仅是一款软件,它是通往未知知识深渊的门户,一个能够思考、学习乃至预测未来的虚拟大脑。随着模型的激活,一台普通的电脑变成了连接现实与未来信息的超级节点。主角在与DeepSeek的对话中,解锁了历史的隐秘,预知了技术的浪潮,甚至触及了人性与AI伦理的边界。

你需要先下载安装Ollama,它是DeepSeek的部署基础,支持多种大模型。接着,在Ollama官网找到DeepSeekR1模型,根据你的设备配置选择合适的版本进行下载。下载完成后,通过Ollama的命令行界面启动模型,即可开始与DeepSeekR1进行本地对话。

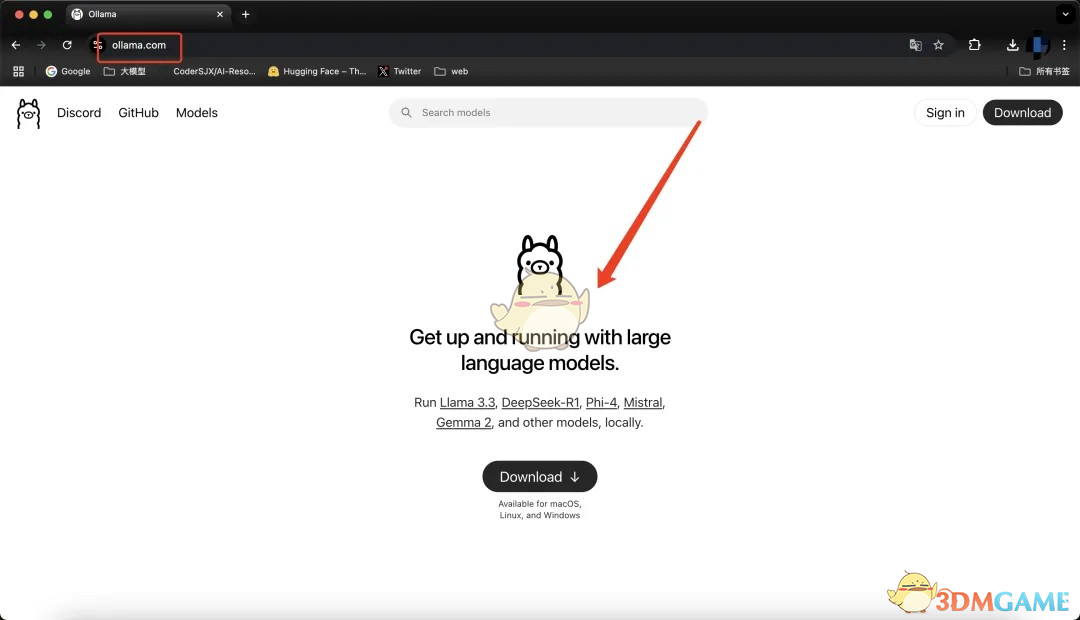

步骤一:下载安装Ollama软件

首先,访问Ollama官网,下载并安装Ollama客户端,支持windows、MacOS和Linux系统。对于国内用户,官网可以直接访问,安装过程也十分简便。

步骤二:运行命令部署DeepSeekR1模型

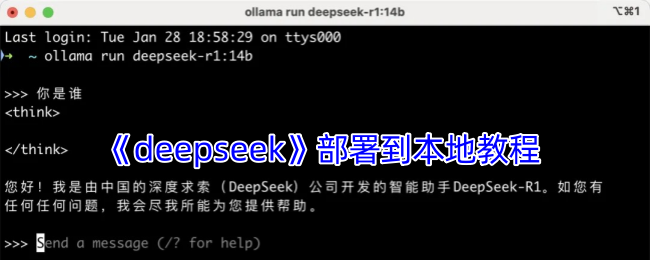

安装好Ollama后,打开命令行窗口,输入以下命令:

bash复制编辑ollamarundeepseek-r1:7b

此命令会自动下载并部署DeepSeekR1的7B模型。

部署成功后,你就可以体验DeepSeekR1模型强大的推理能力了。

如果你希望尝试更高性能的模型,接着看下文的高级特性部分。

高级特性

1、确定电脑是否能运行某个参数量的模型

要确认你的电脑是否能够运行DeepSeekR1模型,关键是看显卡的显存大小。

显卡性能要求相对较低,即使是像1080、2080这样的老显卡,也能运行得相当流畅。

只要显存够用,就可以顺利运行模型。

这里是显卡显存要求的参考表:

显卡要求详情

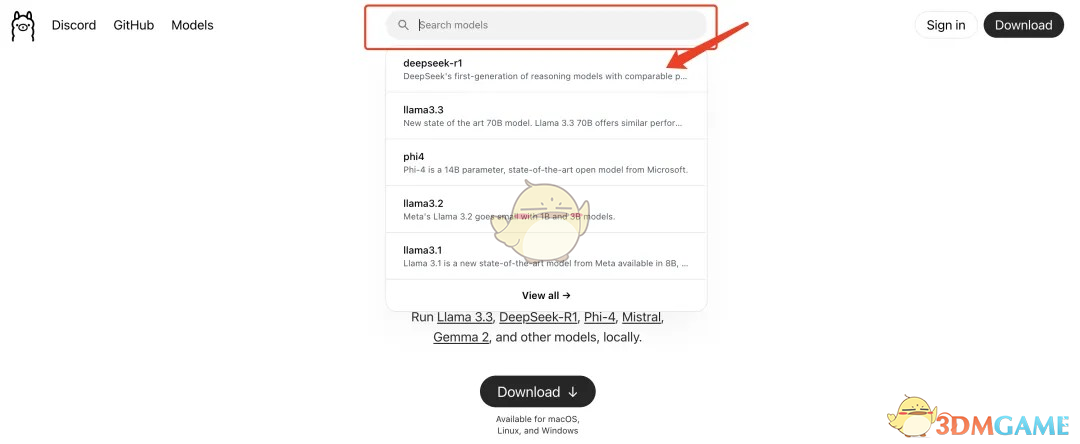

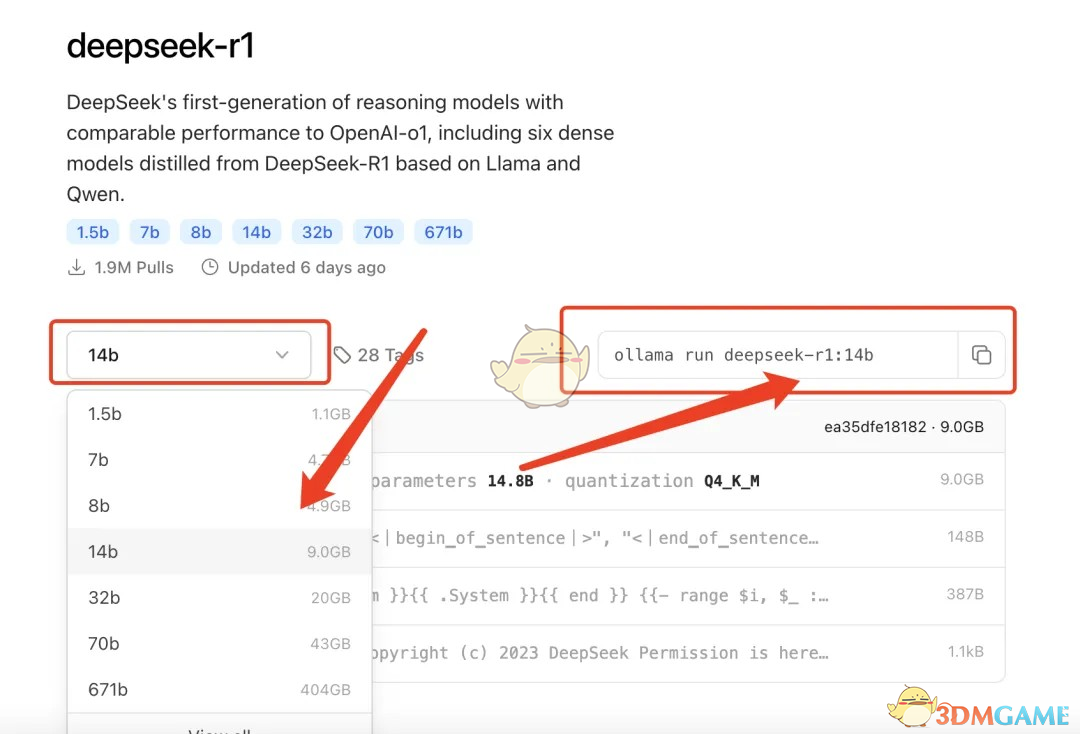

2、运行不同参数量的模型

了解自己显卡的显存后,你可以选择更适合的模型。

通过访问Ollama官网并搜索DeepSeek,你可以找到R1系列的不同参数模型。

模型的参数越大,效果通常越好。

找到你需要的模型后,复制右侧提供的命令,在命令行中运行即可。

3、运行命令客户端

你可以通过以下终端程序运行命令:

Windows:CMD或PowerShell

MacOS:iTerm或Terminal

Linux:任意终端

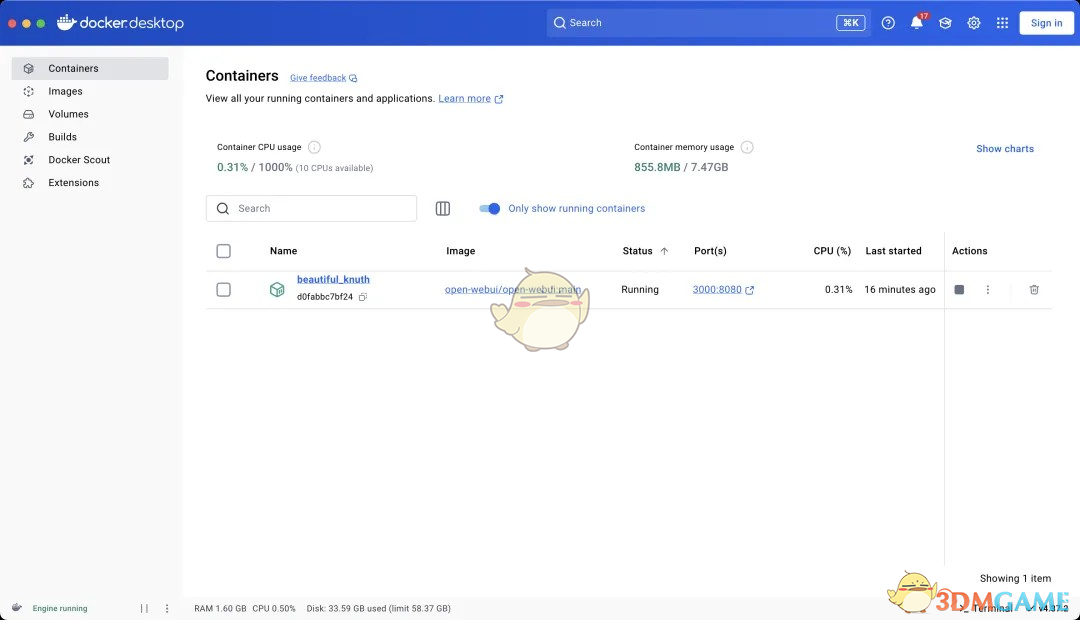

4、使用美观的客户端与模型互动

部署好DeepSeekR1模型后,你可以选择一个漂亮的客户端来与模型进行对话。

一个很棒的开源项目是OpenWebUI,它支持与Ollama部署的模型互动。

你只需填入本地服务的地址localhost:11434即可(默认端口是11431)。

如果你熟悉Docker,还可以通过Docker来运行这个客户端。

另外,如果你需要其他更漂亮的客户端,可以试试Lobe-Chat,它也是开源的,并且非常简洁易用。

以上就是2345下载小编带来的deepseek怎么部署到本地?deepseek在本地部署r1模型教程,更多相关资讯教程,请关注手游网。